決まった時間にWebサイトの情報を取得する

解決できる課題

業務で必要なWebサイトの情報(株価、ニュース、特定ページの更新など)や、Web上のファイル(データファイル、レポートなど)を取得するのに、以下のようなお悩みはありませんか? ・毎日決まった時間にWebサイトへアクセスし、手動でコピー&ペーストや、ファイルをダウンロードする ・Webサイトのステータスを定期的にチェックしたい ・情報収集のタイミングが遅れたり、必要な情報がタイムリーに取得できない このレシピを使えば、指定した時間にWebサイトへアクセスし、必要な情報の抽出やファイルダウンロードが可能です。 これにより、手作業によるミスや時間的コストを削減し、必要なデータを常に最新の状態で、自動的に収集・利用できるようになります。

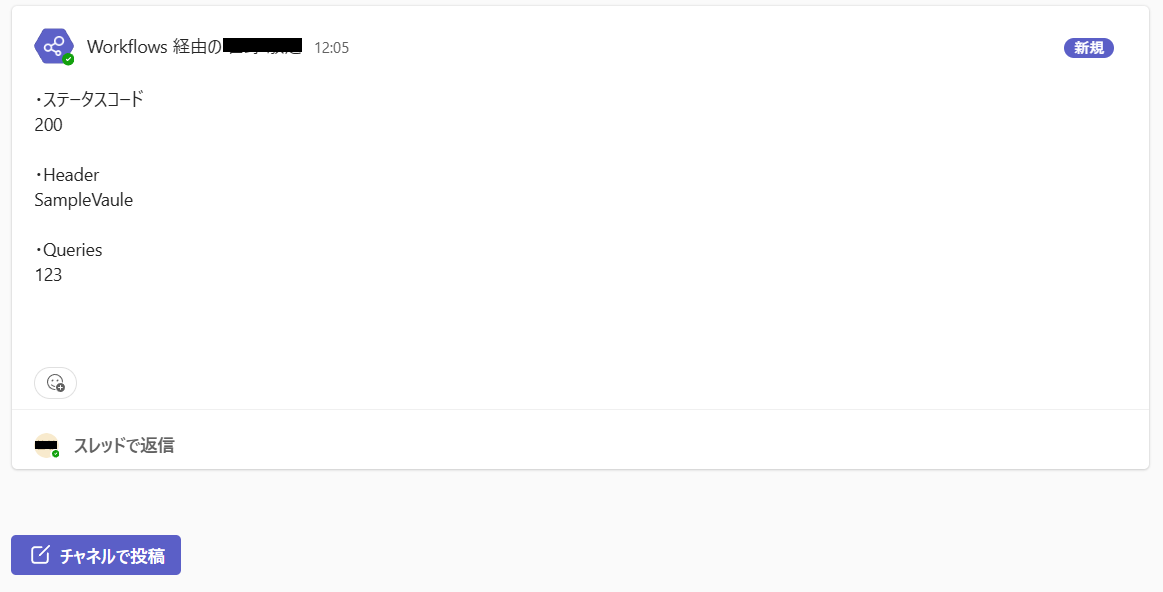

完成イメージ

必要なもの

Http コネクタ

データ操作 コネクタ

Teams コネクタ

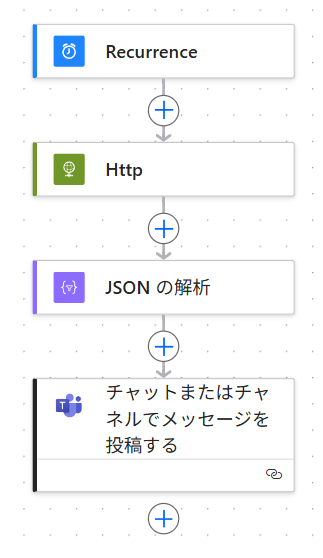

作り方

Webから取得した情報はExcelに転記したり、別のWebサービスと連携させることができます。

今回はTeamsのチャネルへ投稿します。

なお、このレシピで使っているHttpコネクタは、プレミアムコネクタに分類されますが、環境によっては使用可能です。

※私も環境はdefaultで検証しています

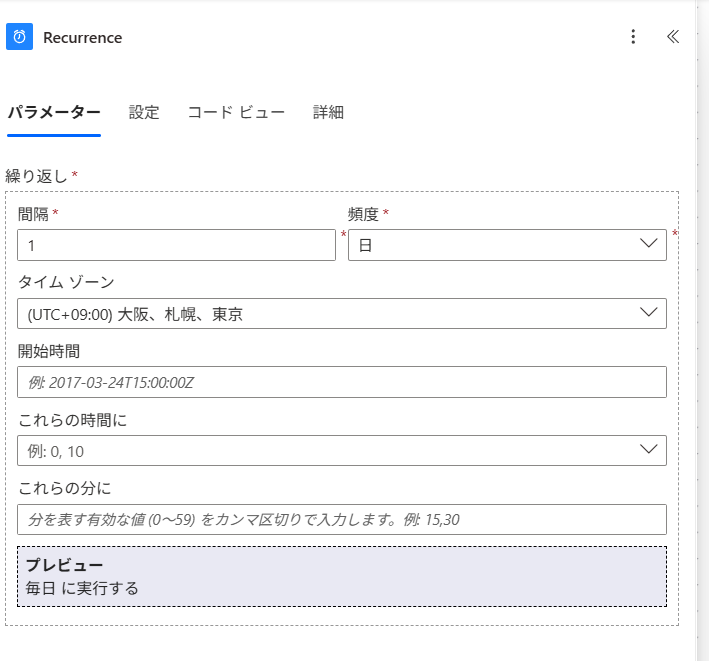

- 1. トリガー「Recurrence」を設定

定期実行にするため、スケジュール済みのトリガーを設定します。

どれくらいの頻度で、いつ開始するか、計画に沿って設定します。

大切なのは、[タイムゾーン]を日本時間にすることです。

- 2. アクション「Http」を設定

[URI]は、WebアクセスするURLを設定します。

※特定のWebサイトも対象にできますが、今回はHTTPリクエストの検証サイトにします

[Method]は、HTTPのリクエストメソッドを指定します。

※どのメソッドを使用するかは、よく調べてください

[Headers]、[Queries]、[Body]、[Cookie]についても、使用はよく調べてください。

このレシピでは、[Headers](ヘッダー)のキーを「Test-Headers」にした場合、「SampleVaule」が返ることを確認します。

[Queries](クエリ)は、「test-queries」にし、「123」が返ることを確認します。

※[Method]を「GET」にしているので、[Body]や[Cookie]は使用しません(「POST」などの送信メソッドでは使用します)

- 3. アクション「JSON の解析」を設定

アクション「Http」から取得するコンテンツは、「Status code」や「Body」です。

このレシピでは、指定したWebサイトからの取得値がJSONのため、「Body」にはJSONが入ります。

取得する全ては必要ないため、この解析アクションで必要箇所を抜き取れるようにします。

[Content]には、「Body」を設定します。

[Schema]には、取得するJSONのスキーマを入力します。

※一から入力するのは大変なので、下部にある「サンプル ペイロードを使用してスキーマを生成する」を使用すると便利です

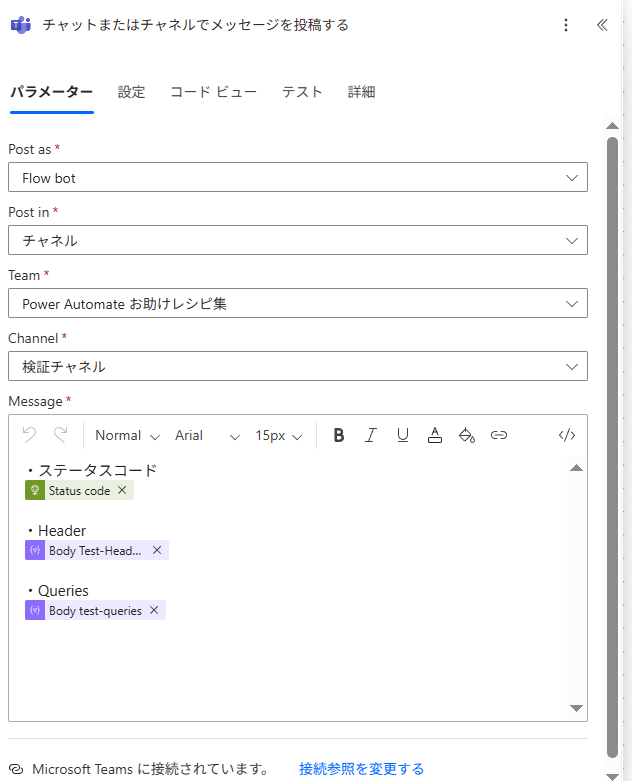

- 4. アクション「チャットまたはチャネルでメッセージを投稿する」を設定

取得した結果を形に残します。

今回は、Teamsのチャネルへ投稿します。

[Message]には、取得した値をそれぞれ記載しています。

「Status code」は、成功したか失敗したかなど、レスポンスのステータスコードを得ます。

他には、今回のレシピでヘッダーとクエリを指定したので、下記の式で取得します。

※ヘッダー: body('JSON_の解析')?['headers']?['Test-Headers']

クエリ: body('JSON_の解析')?['args']?['test-queries']

このフローを実行した結果が下図です。

HTTPリクエストのレスポンスをTeamsに投稿しています。

ステータスコードは200で成功し、ステップ2で設定した通り、Headerには「Test-Headers」とQueriesには「123」が取得されています。